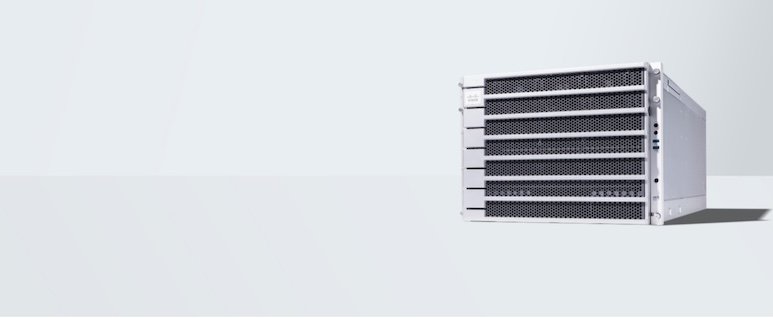

Cisco blijft de AI-infrastructuur opnieuw definiëren met de lancering van UCS C880A M8-rackserver, nu uitgerust met de ultra-krachtige NVIDIA HGX B300 SXM-GPU en de laatste 6e generatie Intel Xeon CPU (Granite Rapids). Dit markeert een convergentie van geavanceerde GPU-versnelling, CPU-verwerking met hoge doorvoer en infrastructuurbeheer op bedrijfsniveau, geoptimaliseerd voor moderne AI-workloads.

NVIDIA: HGX B300: Ongekende AI-prestaties

Gebaseerd op de berichten van NVIDIA op het HGX B300-platform:

– Inferentieprestaties: Tot 11 keer hogere productiviteit voor modellen als Llama 3.1 405B vergeleken met de vorige Hopper-generatie, dankzij Blackwell Tensor Core- en Transformer Engine-optimalisaties.

– Trainingssnelheid: Tot 4 keer sneller voor grootschalige LLM’s zoals de Llama 3.1 405B via FP8-precisieverbeteringen, NVLink 5-interconnects (met 1,8 TB/s bandbreedte), InfiniBand en Magnum IO-software.

– Voordeel van de SXM-vormfactor: Socketarchitectuur met hoge bandbreedte maakt superieure GPU-naar-GPU NVLink-connectiviteit en kabelvrije stroomvoorziening mogelijk, waardoor knelpunten worden geminimaliseerd en de schaalbaarheid wordt vereenvoudigd.

Intel: 6e generatie Xeon CPU: CPU-kracht gecombineerd met AI-versnelling

Aangedreven door de nieuwe Intel Xeon 6 (6700P/6500P) P-core processors, biedt de UCS C880A M8:

– Tot 86 aders per socket verdubbelde geheugenbandbreedte en ingebouwde AI-versnellers, waaronder Trust Domain Extensions (TDX), Advanced Matrix Extensions (AMX), Data Streaming Accelerator (DSA), QuickAssist (QAT) en In-Memory Analytics Accelerator (IAA).

– Ondersteuning voor DR5-6400 en MRDIMM waardoor de geheugendoorvoer nog verder toeneemt.

– Geoptimaliseerd voor Rekenintensieve en hybride AI-workloads — van inferentiepijplijnen tot grootschalige trainingsknooppunten.

Cisco: Intersight-beheer + AI POD-integratie

De AI-infrastructuur van Cisco gaat verder dan raw computing:

– De UCS C880A M8 integreert naadloos met Cisco-interview, Cisco’s op SaaS gebaseerde beheerplatform dat gecentraliseerde controle, zichtbaarheid en beleidsbeheer biedt over de gedistribueerde AI-stack.

– Het past binnen POD AI Cisco Modulaire AI-infrastructuuroplossingen ontworpen voor snelle grootschalige implementatie. Deze gevalideerde datacentereenheden maken het eenvoudiger om AI in fabrieken in te zetten en zorgen tegelijkertijd voor interoperabiliteit met rekenkracht, netwerken en beveiliging.

Belangrijkste gebruiksscenario’s mogelijk gemaakt door HGX B300 (SXM)

De integratie van HGX B300 SXM GPU’s en 6e generatie Xeon CPU’s maakt een reeks AI-workloads mogelijk:

1. Real-time LLM-gevolgtrekking: Gebruik grote modellen zoals Llama 3.1 405B met ultralage latentie en hoge doorvoer, ideaal voor chatbots, agenten en realtime redeneren.

2. Trainen en tunen van grootschalige modellen: Maak gebruik van 4x snellere training en enorme inter-GPU-bandbreedte om modellen met honderden miljarden parameters te trainen of af te stemmen.

3. Hoogwaardige AI-pijplijn: Maak gebruik van CPU-offloading voor gegevensvoorbereiding en -orkestratie, samen met GPU-versnelling, voor ETL-workflows, multimodale verwerking en inferentie.

4. AI-native datacenters/AI-fabrieken: Creëer samenstelbare, veilige en schaalbare AI-infrastructuurblokken met Cisco AI POD’s, klaar voor integratie in datacenters of aan de edge.

5. HPC en wetenschappelijke simulatie: Voer aaneengesloten geheugenmodellen en multi-GPU-workloads uit met verbeterde NVLink-connectiviteit voor hifi-simulaties en analyses.

Overzichtstabel

Onderdeel

Maak duidelijk

GPU

NVIDIA HGX B300 SXM: 11× gevolgtrekking, 4× training, NVLink 5 bandbreedte: toonaangevende AI-versnelling

verwerker

6e generatie Intel Xeon P-core (tot 86 cores), DDR5-6400, geïntegreerde AI-versnellers

Platform

Cisco UCS C880A M8 met Intersight-integratie: schaalbaar, georkestreerd en bedrijfsklaar

Ecosysteem

Cisco AI POD + Secure AI Factory + sterke interconnectie (netwerk, beveiliging, validatie)

Gebruiksgevallen

LLM-inferentie/training, AI-pijplijn, AI POD-implementatie, HPC-workloads

Finale Gedachten

DE Cisco UCS C880A M8: HGX B300 met 6e generatie Intel Xeon zet een nieuwe maatstaf voor AI-infrastructuur. Het biedt hyperscale AI-prestaties, robuuste CPU-ondersteuning, beheerbaarheid op ondernemingsniveau via Intersight en veilige implementaties via Cisco Secure AI Factory met Nvidia Scalable-architecturen en Cisco AI POD. Of u nu een AI-trainingscluster, een LLM-inferentie-engine of een samenstelbare AI-infrastructuur bouwt, dit platform is speciaal gebouwd voor de volgende grens van AI. Ontdek de kracht van de AI-infrastructuur van de volgende generatie: lees Cisco UCS C880A M8-gegevensblad.

BRON